J’ai déjà souvent parlé de Luminar sur ce blog.

La dernière fois que je l’ai fait, c’était à propos de la sortie de sa dernière version, Luminar AI.

Vous savez donc que, si je n’ai aucunement envie d’en faire mon logiciel principal concernant la photographie puisqu’il est assez nul en matière de catalogage, Lightroom étant immensément plus fort sur ce point, j’ai du plaisir à l’utiliser afin d’améliorer une ou deux photos, de ci, de là, quand le besoin s’en fait sentir.

Il faut bien admettre, comme je l’ai écrit pour la dernière fois ici, que son intelligence artificielle fait merveille et nous évite d’effectuer tout à tas de retouches chronophages sur nos RAWs.

La dernière version de Luminar AI, l’update 4, gratuite pour ceux qui ont acheté Luminar AI dans une version précédente (attention, il faut bien avoir acheté Luminar AI pour en profiter, les anciennes versions ne sont pas éligibles à la gratuité, juste à un rabais), améliore encore l’ergonomie du logiciel.

Commençons par les petites améliorations

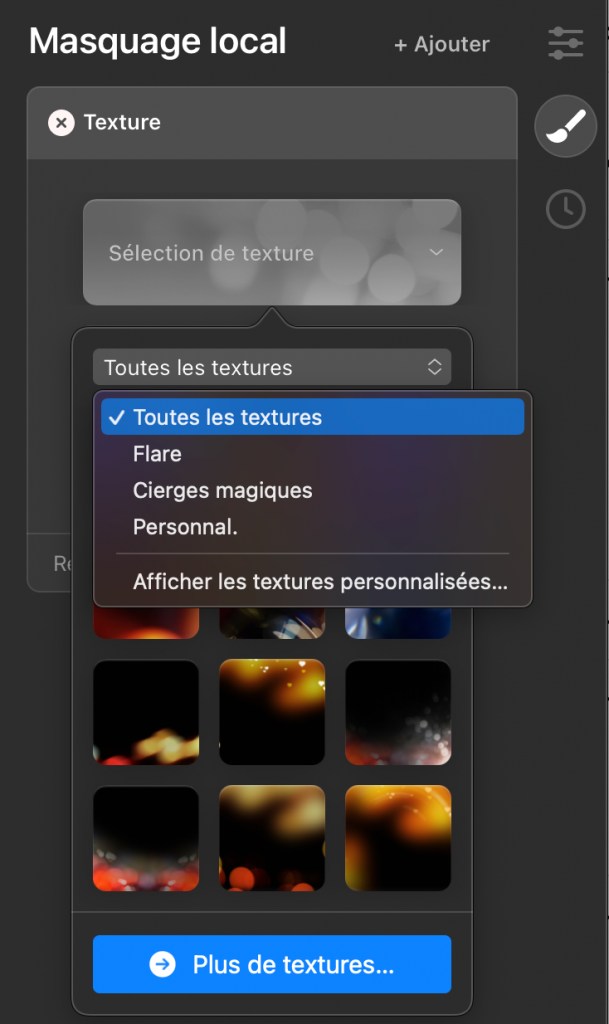

Les textures (jeux de lumières, flare, effets de bougies…) que l’on retrouve dans le masquage local, nous permettent désormais de voir ce qu’il en est de l’effet avant de l’appliquer.

Autre outil intéressant qui a été amélioré (il l’avait déjà été dans une moindre mesure dans les précédents updates de la première version AI dont je n’ai pas parlé), le remplacement de ciel qui est toujours plus efficace en matière de reflets, et qui permet désormais de bien mieux placer l’horizon, en tout cas plus simplement.

Je vous montre avec un petit film:

L’effet Bokeh

Si vous avez un Smartphone un peu récent, vous savez à quel point la technologie permet désormais de simuler la très faible profondeur de champ générée, par exemple, par le fait de prendre un portrait avec une grande ouverture (f1.8, focale 85 mm à 1.5 m d’une personne) avec un objectif traditionnel.

En résumé et pour faire court, l’intelligence artificielle de votre téléphone reconnaît le sujet au premier plan, le détoure à la volée et applique un flou sur tout le reste.

Bien évidemment, ces effets de bokeh sont plus ou moins naturels et ils n’arriveront jamais au même résultat que ce que nous pouvons faire avec un bel objectif et les lois de l’optique qui y sont associées.

Cela étant, ils sont pratiques parfois pour dissimuler un container à l’arrière d’un beau portrait pris sur le fait sans avoir eu le temps de poser et de composer son image.

Il a toujours été possible d’ajouter un effet de bokeh à nos images artificiellement, mais pour ce faire, il fallait détourer le sujet de premier plan qui devait rester net, et cela pouvait prendre au profane que je suis un temps interminable.

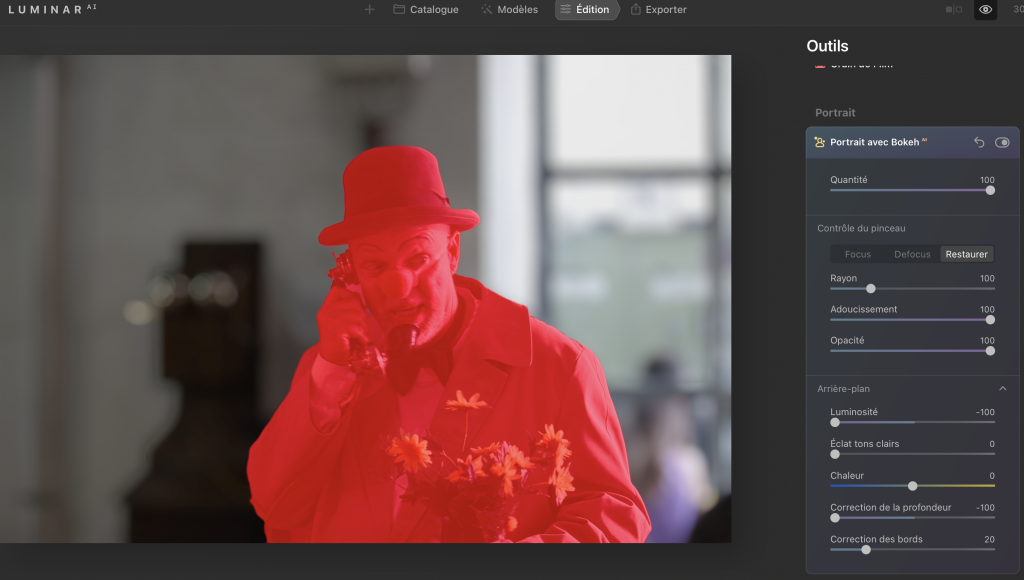

Luminar AI vous permet désormais d’obtenir un effet de bokeh en se chargeant lui-même du détourage de manière souvent très précise, et en moins de 2 secondes.

Un exemple:

Pour arriver à ce résultat, vous voyez que le programme a masqué à la perfection le sujet.

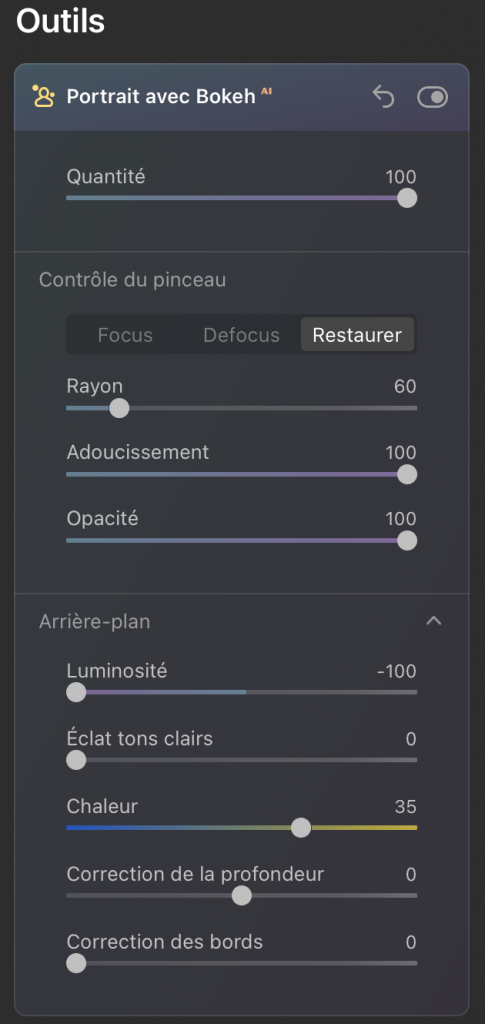

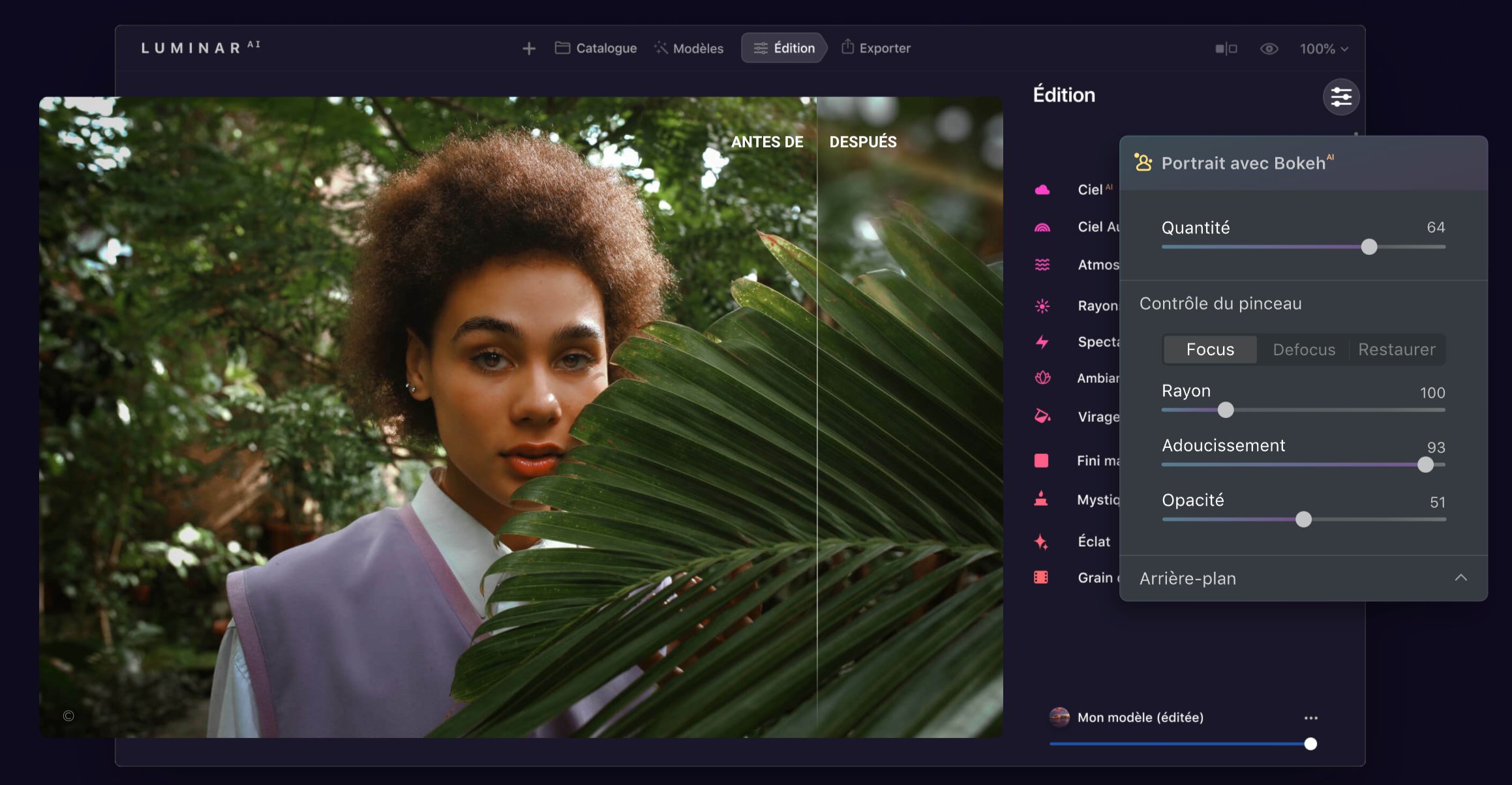

Comme vous pouvez le voir sur l’image précédente, un certain nombre de réglages sont disponibles pour cette fonction de bokeh.

Tout d’abord la quantité de l’effet, qui est importante certes, mais directement liée à l’avant-dernier curseur « Correction de la profondeur ». Si ce dernier est à +100, vous ne verrez pratiquement pas d’effet bokeh.

Les outils « Contrôle du pinceau » vous permettront d’augmenter le masquage (Focus) ou de le diminuer (Defocus) en gérant l’adoucissement et le rayon du pinceau.

Je dois dire que lorsque j’ai voulu utiliser ces outils de Contrôle du pinceau, j’ai fait plus de mal que de bien, notamment lorsqu’il s’est agi d’améliorer le détourage de quelques cheveux fous.

Dans ce cas, pas de panique, le bouton « Restaurer » retrouve le masque effectué par Luminar.

Restent les outils d’arrière-plan qui sont intéressants, notamment celui dédié à la correction de la profondeur qui impacte directement l’effet bokeh, comme je l’ai écrit plus haut, et les outils Luminosité ainsi qu’Eclat tons clairs qui permettent de faire ressortir le sujet.

Mais que ce soit bien clair: Luminar AI peut et va encore s’améliorer.

En effet, dans des photos de groupes, il se perd totalement, et il ne reconnaît pas les premiers plans autres que les humains. Un objet ou un animal ne sont ainsi pas encore reconnus.

Et surtout, dans les sujets difficiles comme les portraits de femmes avec des cheveux un tantinet sauvages, le logiciel doit également s’améliorer.

En conclusion

Encore une fois, je sais, je me répète, Luminar ne sera jamais mon logiciel au quotidien pour gérer ma photothèque, il en serait bien incapable d’ailleurs.

C’est bien dommage quelque part, parce que ses fonctions d’améliorations automatiques de l’image, je ne parle même pas des remplacements de ciels ou d’ajouts d’objets dans ces derniers qui sont pour moi du domaine du gadget que l’on va utiliser rarement à moins d’être un adepte de ces choses, ce que je ne suis pas, ces fonctions d’améliorations automatiques de l’image, donc, sont vraiment assez étonnantes et permettent de gagner un temps précieux en postproduction.

Ici, l’ajout du bokeh fait partie des petites choses qui peuvent rendre service, même si cet ajout reste en deçà de ce que vous obtiendrez avec un bel objectif lumineux à grande ouverture (ah, les effets des lamelles de nos diaphragmes, c’est tout de même autre chose qu’un flou logiciel un peu plat!),

Cela étant, en dehors de Lightroom qui est ma base, il est deux logiciels photographiques dont je ne me séparerai pas, c’est Luminar et DxO.

Donc je suis très content que Luminar continue à évoluer et nous offre de nouvelles fonctions, ici gratuitement, je le rappelle, pour les utilisateurs enregistrés de Luminar AI.

Luminar AI avait obtenu le label Too Much Bô.

Il le conserve dans cette nouvelle version, bien évidemment.

En savoir plus sur Le Blog du Cuk

Subscribe to get the latest posts sent to your email.

Pour moi, AI = bof ! Artificiel est bien le bon mot. Comme dit dans l’article : 85 mm/1:8, y pas mieux !

Merci de ce retour. En effet, le numérique peut imiter l’optique… mais il restera toujours une différence. Et si l’AI n’était pas si intelligente que ça, comme le dit Julien Pons.

Si, 1.4! Mais un seul œil est net alors!?

Je suis fan du bokeh ! Est-ce qu’il reprend les couches de profondeur de l’iPhone par exemple ? Parce qu’un bokeh avec seulement 2 niveaux, c’est bof…

Y a Focos qui est pas mal sur iOS également.

Le problème est effectivement toujours le détourage des cheveux: on se retrouve avec une coupe littéralement au carré ?

Hello!

J’ai regardé ton film, merci beaucoup.

Julien Pons et moi, nous sommes parfaitement d’accord.

Je précise que moi non plus, je ne suis pas sponsorisé par Skylum même s’ils m’ont proposé de devenir ambassadeur, ce que j’ai refusé, bien sûr.

Cela dit, Skylum n’est pas pire que CaptureOne ou ON1 qui nous inondent de leurs pubs plusieurs fois par semaine, comme je l’ai écrit ici:

D’ailleurs, pour ceux qui en doutaient, faites une recherche sur Luminar sur mon site et vous verrez mes colères piquées à leur encontre, notamment parce qu’ils ont mené toute une communauté de photographes en bateau à propos de leur soi-disant remplacement de Lightroom.

Entre autres:

Je n’aime pas cet éditeur, cela étant, force est de constater que, comme le dit Julien et comme je le dis dans l’article, Luminar AI est pratique et fait bien le job au coup par coup.

Et dans ce cas, Luminar AI est super et je l’apprécie.

Pour le reste, DxO et Luminar.

Je ne pense pas qu’il reprenne les données du Lidar, et Apple me semble faire mieux dans ce domaine, mais seulement avec l’iPhone.

Oui, Focos n’est pas mal, c’est vrai.

En fait, le seul point sur lequel mon article ne va pas dans le sens de ce qu’il dit, c’est sur l’emploi de l’intelligence artificielle. En effet, il a peut-être raison, après réflexion.Quoique… dans le détourage automatique des personnages, on peut tout de même parler d’AI et de deap learning, je pense.

Entre 1.4 et 1.8 sur un 85 mm « vissé » sur un FF, la différence de profondeur de champ est de 3 mm.

Ma référence SetMyCamera: https://www.setmycamera.com

Je fais part de ma compréhension: Julien et François disent, différemment, la même chose: Luminar AI est un logiciel de trucage d’image. Ça va vite, c’est simple, on ne consomme pas de temps à analyser l’image, à comprendre les points forts et faibles. Fastoche, tu cliques: ça te plait, tu gardes, sinon tu annules et tu vas cliquer ailleurs.

Luminar « AI » est bien dans l’air du temps

Message technique: peut-on éviter ici les appréciations « c’est pas mal », « un peu » et autres imprécisions passe partout. Fin du message technique

Oui ou simplement les données croisées entre les 2 focales 25 et 50 qui permettent d’obtenir une couche de profondeur (sur tous les iPhones qui ont l’objectif portrait)

Si la technologie permet de produire un bokeh réaliste depuis un smartphone grâce à d’autres éléments physiques, comme un scanner Lidar ou des doubles objectifs, je trouve que c’est positif et permet d’emporter son appareil toujours avec soi.

Par contre, ajouter des éléments dans une scène me parait effectivement farfelu.

Sans compter que le meilleur piqué n’est pas situé aux extrêmes de l’ouverture.

Les logiciels de ce genre me laissent une impression bizarre.Autant j’admire encore et encore les photos de Sebastião Salgado ou de Marcel Imsand, ou d’Henri Cartier-Bresson (entre autres), autant je ne sais trop quoi penser des logiciels faisant appel à l’IA d’une manière qui peut être extrêmement intrusive.Parce que tout est là, il en faut, peut-être, mais alors vraiment très peu.Il en va de même des compositions musicales créées par des ordinateurs bourrés d’IA, dans le style de Beethoven, ou de Mozart par exemple. C’est à s’y tromper parfois.Bien sûr, lors du tirage de leurs photos, ces photographes jouaient avec les gradations des papiers ou faisaient des ombres avec leurs mains ou des caches bricolés et en mouvement sous leur agrandisseur, Imsand en est un exemple qu’il fallait voir travailler.Mais ça n’allait guère plus loin.J’imagine qu’il y aura une fois des sculpteurs qui présenteront leurs créations dans un musée d’art moderne. Elles auront été créées par impression 3D.Peut-être d’ailleurs que ça existe déjà, je n’en serais pas étonné.

Je te suis tout à fait…

Pour ma part, Capture One quand j’ai le temps, Lightroom pour tout recentrer… et Luminar 4 ou AI (je ne sais plus) pour ma fille de 9 ans.

Est-ce le plus meilleur parfait système ? Je ne sais pas… mais ça me va, ça me sort de belles photos, et ça me permet d’avoir un flux de travail qui me permet de suivre plus ou moins mes prises de vue !

Bon… Capture One, j’ai acheté la dernière version, mais vraiment, je crois que je vais laisser tomber.

Lightroom au centre et quelques plug-ins, c’est tout de même le top!

Tout à fait d’accord.

Bon… sur l’impression 3D, il faut être un artiste dans le dessin pour arriver à sortir quelque chose de correct j’imagine, alors pourquoi pas?

Alors je ne sais pas ce que dit la théorie, mais pour moi, un 85 mm 1.4 ne laisse rien passer comme différence de plan, alors que le 1.8 un peu plus.

3mm? Il me semble bien que c’est plus.

Le pire, c’est quand j’avais mon 85 mm f1.2 de chez Caonon!

Non, bien sûr, mais c’est souvent super utile d’utiliser ces objectifs super lumineux.

Notamment justement pour être à f2.8 avec un 85 mm avec déjà des améliorations de piqué puisque tu n’es pas aux extrêmes…

Sans compter que la profondeur de champ varie avec la distance boitier-sujet.

Essayez cette app SetMyCamera: tout y est.

J’ai les deux, LrC et C1, quand je passerais à l’iMac M2 vitaminé en 32 pouces je prendrais la décision de me passer de C1, et si possible de Rosetta. L’idéal serait de coupler LrC avec DxO PL4

610d6eaa12ad792a31ce6ec7.png

Caplan, ton dessin est à montrer à Julien Pons. Merci

Magnifique. Voilà tout ce que j’en pense en une image. Le monde est flou, flou, flou…

Version corrigée:

610d8dbc1430d93d71a3e739.png

C’est vrai que Capture One est complexe… mais avec Fuji, le dématriçage est plus précis et les réglages sont plus fins… c’est mon avis.

Mais pour la création de rendu, je repasse par Lightroom… 10 ans d’expérience, ça compte.

Corrigé ou pas, c’est dingue, digne des Mic et Mac de l’époque, avec d’autres personnages ici de Mix et Remix, qui nous manque (sans nt à la fin de manque puisque ce n’est qu’une personne).

Merci! ?

Intéressant… pourquoi DxO plutôt que C1 ? Pour la réduction du bruit ?

Avec quelle marque photographiez-vous ? ça m’intéresse…

Parce que (je réponds pour moi, peut-être qu’Albert est dans la même situation), DxO me semble d’une part supérieur dans son domaine d’amélioration de l’image que C1, notamment dans la réduction de bruit, et que de l’autre, j’ai un peu l’impression que C1 joue dans le même registre que Lightroom.

Je n’ai pas l’idée d’utiliser C1 pour améliorer une image cataloguée dans LR, je préfère les spécialistes de la question dans chaque domaine.

« faites une recherche sur Luminar sur mon site »

Et bien tu peux même le faire pour nous et ensuite copier-coller l’URL:https://leblogducuk.ch/?s=luminar

?

(J’ai « découvert » ça sur wp l’autre jour en bidouillant autre chose…. )

En effet, tu as raison, formidable WordPress.

Cela dit, je ne vais pas tout faire non plus hein, faut que je vous garde un peu d’exercice, ou bien? ?

Finalement, après hésitations, tests divers, DxO est plus apte à corriger des images nocturnes fortement bruitées, sous 3200 ISO DeepPrime ne sert à rien à ce niveau. Par contre il pourrait très bien remplacer LrC, eh oui, à condition de monter la structure d’accueil des photos sur le modèle de Lightroom, AAAA ./. AAAA-MM ./. AAAA-MM-JJ. Il sait également redresser les photosReste que je privilégie de classer mes photos avec LrC (Classic) , il est parfait pour la majorité des opérations, corrections de base, la localisation après coup, l’exportation en JPG vers Photos par exemple.Capture One importe bien les ProRAW d’Apple, des DNG Linéaires, qu’il opacifie d’entrée, l’automatisme permet de corriger cela. Après 4 ans passés à tester ces trois logiciels, j’arrive au point où je peux dire que la paire LrC et DxO PL 4 Elite s’en sort très bien. Dans C1 je mets les photos en mode référencé, donc en puisant depuis ma structure favorite…Actuellement, j’utilise un Canon Powershot G1X Mk iii, c’est un APS-C, son range de 15-45 me convient très bien, je l’utilise majoritairement en restant sur l’ouverture 15, j’ai encore un Nikon D7500 prêté en famille, je n’ai plus le Sony a6500, le D5300 (le meilleur que j’ai eu) le Canon 750D.Mon tout premier APN était un Casio QV-300-EX qui est malheureusement tombés dans un torrent. Dernier point, je trouve que de nos jours la location de logiciels rentre dans les moeurs, c’est un poste constant dans les dépenses liées à l’informatique, toujours moins cher que de changer chaque année d’APN, vraie source de vide poches

Merci de cette réponse tout à fait pertinente. Pour moi, avec Fuji, Capture1 est un cran au-dessus de LR pour le développement des RAW… mais c’est propre à Fuji, de ce que j’ai lu.

Merci Albert… je plussoie tout à fait… gardant « l’exception » Fuji. As-tu un site ou une page de réseau social pour que j’admire tes photos ?

Si le Fuji X100V était stabilisé je l’aurais pris à la place du Canon G1X Mk iii

Avec l’âge il faut ajouter les petits tremblements

Je comprends tout à fait.

Non, je fuis tous les réseaux, je viens de quitter le forum Chasseurs d’Images, FB ça fait un bail.

Une page web ? ?

La seule chose qui traine encore sur le Web c’est ma généalogie

OK, dommage…

En effet, j’ai cherché: RIEN! Même pas tes commentaires ici, et même pas ta généalogie!?

Elle est sur Généanet, ils font du bon boulot, noyautée comme il se doit

Oh tu sais, je dis toujours que ce que je fais de mieux c’est « rien faire ». 🙂

Tu as bien de la chance, je suis nul dans ce domaine.

Quoique… depuis un an, il me semble que je progresse…

Lorsque j’ai commencé à faire de la photo, on ne parlait pas de bokeh. Je ne sais pas quand ce terme est arrivé dans le langage photo ni qui est responsable de sa propagation. Personnellement, il me fait doucement rigoler. Avant le bokeh, tout photographe un peu informé savait ce qu’était la profondeur de champ et ce qu’elle permettait de faire et notamment dans le domaine du portrait (ce que l’on appelle un flou d’arrière-plan) et en faisait l’usage qui lui semblait le meilleur. La profondeur de champ fait partie du B.À.Ba de la photo et c’est une technique assez simple à mettre en œuvre. L’utilisation d’un mot japonais par des snobinards et des pignoufs pour désigner cette technique m’agace au plus haut point.

Pour revenir à ce qui a été dit à propos des zones de netteté devant et derrière la distance de mise au point, voici ce que j’ai trouvé concernant l’utilisation d’un 85 mm sur un reflex plein format (24×36) :

Pour une mise au point réglée à 1,50 mètres :

à f1.4 la zone de netteté sera de 2 cm, entre 149 et 151 cm,

à f/1.8, elle sera de 3 cm,

à f2 elle sera de 4 cm,

à f/2.8 elle sera de 5 cm,

f/5.6 – 10 cm,

f/11 – 19 cm,

f/22 – 39 cm.

On trouve sur l’App Store diverses petites apps pratiques pour aider à faire les bons choix (faire une recherche sur « depth of field »). Pour moi, qui aime le portrait, f/1.8 suffit largement et, en réalité, je choisis plutôt f/2.8 quand je peux, un œil sur deux flou ne me plait pas. On y parle aussi de l’hyperfocale, pour ceux qui savent encore de quoi il s’agit.

Pour finir, concernant l’usage artificiel de la profondeur de champ par des logiciels tels que Luminar AI (ou l’iPhone lorsque l’on choisit l’option portait), je trouve le résultat assez piteux, il y a toujours un détail qui est flou alors qu’il ne devrait pas, un autre qui est passé à la moulinette logicielle et le résultat est un ou plusieurs artefacts, etc… Si vous prenez une personne en portrait avec un objet (ou plusieurs objets) sur le même plan focal que cette personne, cet objet sera flou (un livre, une fleur, etc…). Je viens d’en faire l’expérience et c’est ballot !

Bref, pour l’instant (car des progrès sont possibles et probables), l’AI je m’en méfie. Et pas seulement dans le domaine de la photo…

Ces quelques mots vous sont envoyés de Céphalonie (Kefalonia en grec) où la connexion est assez maigrichonne. Par contre l’île est magnifique ! Elle a servi de décor à ce beau film qui s’appelle « La Mandoline du Capitaine Corelli » (d’après le roman éponyme de Louis de Bernières, écrivain britannique malgré son nom), avec Penelope Cruz, John Hurt et Johnny Cage.

Oui, le terme de bokeh m’agace aussi. Il doit avoir 15 ans chez nous de vie dans tous les journaux.

Mais bon, tout le monde l’utilise, on a presque l’air ringard d’utiliser flou d’arrière-plan…

Content de savoir que Kefalonia ne brûle pas… Quelle horreur, ce qui se passe en Grèce en ce moment…

Un article intéressant de Wikilivres sur le sujet.

Il me donne raison dès le premier paragraphe…

Bonjour à tout le monde

Chaque optique a ses caractéristiques. 1.2 ou 1.4 ou 1.8 etc ne sont pas des dogmes. On peut aimer une optique pour son rendu en général et l’on peut acheter une optique à très grande ouverture sans être un fan des grandes ouvertures mais parce que son rendu nous plait.

Quant à l’AI intégrée dans les logiciels, cela peut rendre service. Il y a beaucoup de choses que Luminar AI ne fait pas mieux (bien au contraire) que manuellement avec PS, mais juste plus vite. Lorsque l’on travaille par exemple beaucoup en studio, comme moi, avec un fond gris moyen à 50%, cela permet d’incruster un fond, une texture plus rapidement avec l’AI dans la zone des cheveux. Quand je fais cela pour moi, je le fais de manière manuelle, quand c’est pour la clientèle, cela dépend du budget.

Giampaolo

http://www.arteplus.ch